PYTHON实现RNN算法

实现学习二进制的加法。

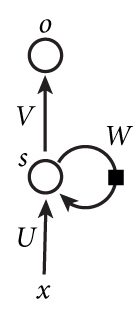

如上图所示,我们来手写RNN算法:

代码:

1 | #!/usr/bin/env python |

结果:

1 | 损失值:[3.45638663] |

转载请注明:Seven的博客

如上图所示,我们来手写RNN算法:

1 | #!/usr/bin/env python |

1 | 损失值:[3.45638663] |

转载请注明:Seven的博客

本文标题:递归神经网络之python实现RNN算法

文章作者:Seven

发布时间:2018年08月29日 - 00:00:00

最后更新:2018年12月11日 - 22:10:26

原始链接:http://yoursite.com/2018/08/29/2018-08-29-DL-RNN-hand/

许可协议: 署名-非商业性使用-禁止演绎 4.0 国际 转载请保留原文链接及作者。

微信支付

支付宝